wespiva - Web Spider Validator

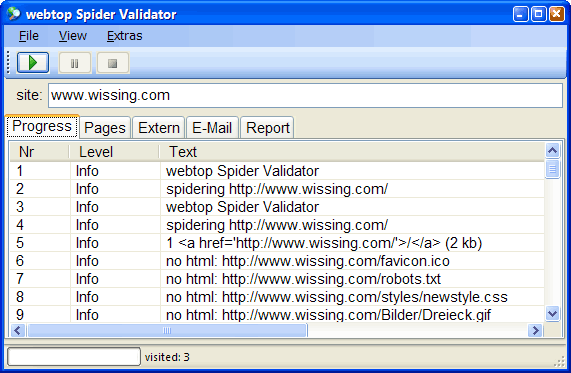

Web Spider Validator, oder kurz wespiva, ist eine Mischung aus einem

- Web-Spider (Robot, Crawler) , der alle Links einer Site durchwandert und dabei tote Links findet,

- und einem XHTML-Validator, der jede besuchte Webseite auf XHTML-Konformität überprüft. Dabei werden die HTML-Tags, die Attribute zu den Tags, und auch die Attributwerte geprüft.

Inhaltsverzeichnis

Beschreibung

Der Zweck dieses Werkzeugs ist

die Sicherstellung von hochqualitativen

standardkonformen Web-Sites.

Mit

Xenu's Link Sleuth

existiert schon ein großartiges Programm

um eine Site zu spidern und tote Links zu finden,

aber Xenu validiert die besuchten Webseiten nicht.

Mit dem

w3.org-Validator

gibt es ein hervorragendes Validierungs-Tool,

aber es wird immer nur eine einzelne Webseite geprüft, keine ganze Site.

Zudem ist der w3.org-Validator manchmal langsam oder nicht erreichbar,

oder sie möchten nicht den Inhalt ihrer Seiten an Dritte geben.

Die Lösung dieser Restriktionen ist wespiva,

der gleichzeitig die Links validiert und die Webseiten

auf XHTML-Konformität

validiert, alles in einem Rutsch.

wespiva ist damit auch sehr hilfreich in

der periodischen Prüfung von bestehenden Sites,

um dort schnell tote Links oder defektes XHTML aufzufinden.

Aber auch bei der Transition einer Site

vom veralteten HTML-Wildwest Tagsoup zu einer

modernen XHTML-konformen Site hilft wespiva.

Download

Hier klicken zum Download von

wespiva

Version 4.2012.6.21689

(166 kb ZIP-File, 2012-06-29)

Auch wenn wespiva nach bestem Wissen und Gewissen programmiert wurde, besteht die Möglichkeit eines Absturzes oder von Programmfehlern in der Anwendung selbst oder einer der benutzten .NET-Bibliotheken. Diese Fehlfunktionen könnten zum Absturz führen.

Damit ich nicht verantwortlich gemacht werden für daraus resultierende Datenverluste, Zeitausfälle oder fehlerhafte Reports des Programms, darf das Programm nur auf eigene Gefahr genutzt werden. Einsatzbedingungen:

- Vor Einsatz ein Backup aller Daten durchführen - wie es die Regel sein sollte.

- Sie werden mich nicht für irgendwelche Schäden verantwortlich machen, es sei denn, ich hätte diese Schäden bewußt provoziert.

Installation

Voraussetzungen

wespiva läuft unter Windows mit installiertem

NET Framework 4.0.

(Vorversionen: NET Framework 3.5)

Wie führt man das Programm aus?

Einfach die heruntergeladene ZIP-Datei öffnen und die darin enthaltene EXE-Datei und die zwei Hilfsdateien auspacken und starten - fertig!

FAQ - Häufige Fragen zum Thema wespiva

- Läuft wespiva unter MONO für Windows?

- Ja, eine Spezialversion von wespiva läuft unter Mono 2.2, allerdings hängt die Applikation, wenn das Applikationsfenster verändert werden soll, während wespiva gerade eine Website spidert. Die Ursache ist unbekannt, offensichtlich hat Mono noch Probleme mit Windows.Forms und Multithreading. Wenn während des Spiderings die Benutzeroberfläche von wespiva in Ruhe gelassen wird, bis er durch ist, funktioniert es.

- Wird es eine MONO-Version für Linux/OS-X geben?

- Vielleicht — wenn jemand es bezahlt.

- Wie viele Webseiten können in einem Rutsch untersucht werden?

- Es wurden damit schon Sites mit mehr als 50.000 Elementen in weniger als 15 Minuten geprüft. Die Dauer der Prüfung hängt primär von der Leitungs-Bandbreite und der Antwortzeit des untersuchten Webservers ab.

- Warum überhaupt Validation?

- Ich möchte hier andere schreiben lassen:

Samples

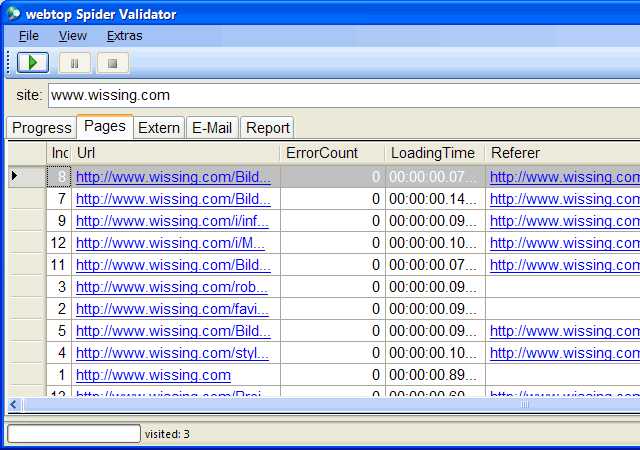

Features

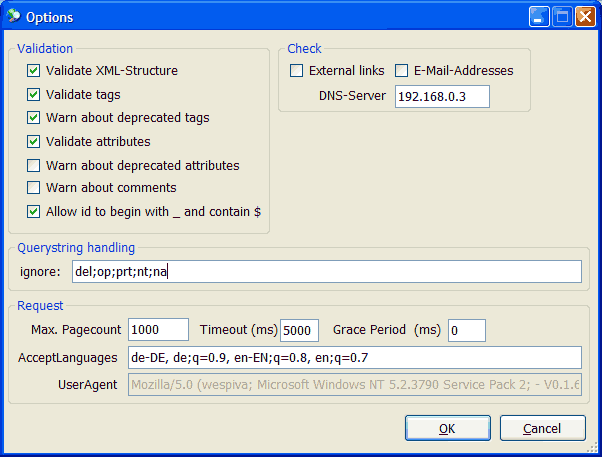

- einfach zu benutzen

- einfach zu installieren (es ist nur eine EXE-Datei, die direkt gestartet werden kann)

- schnell (kann mehr als 50.000 Element in weniger als 15 Minuten prüfen)

- der Validator ist im Programm enthalten, wespiva kann auch im reinen Intranet benutzt werden.

- Findet tote Links

- Findet XHTML-Validierungs-Probleme und Fehler

- Erzeugt eine einfach zu verstehenden Ergebnis-Zusammenfassung

- Kann eine Sitemap im Standard-Sitemap-Format von google erzeugen.

- Aufruf per Kommandozeile für die periodische automatische Prüfung einer Site ist möglich

- Das Spidern und Validieren erfolgt in einem Hintergrundprozess, so dass die Bedienoberfläche immer reaktiv ist

- Einfache Konfiguration von Spider- und Validierungs-Parametern

-

Bilderprüfung:

- Kann das Bild gemäß dem spezifizierten Bildformat korrekt geladen werden?

- Liegen alle Bilder in web-gerechter Kompression vor? Für diese Prüfung können Sie den gewünschten Kompressions-Qualitätslevel selbst festlegen. Sie können auch einstellen, ab wie viel Prozent Ersparnis eine Meldung stattfindet.

- Enthält eines der Bilder verräterische Meta-Daten, die noch nicht entfernt wurden?

Aufruf per Kommandozeile

c:\wespiva.exe "www.wissing.com" "example@example.not"

Bekannte Fehler

- Es werden noch nicht alle HTML5-Tags und -Attribute zu 100% geprüft.

-

Sites, die das

base-Tag benötigen, werden nicht korrekt gespidert.

Zukünftige Features:

- https-Support

- Online-Version

- Multi-Threading beim Spidern und Validieren

- Vorschaubild für jede besuchte Webseite und andere Ressourcen (Bilder, PDF)

- Prüfen von inline-Anchor-Href-Beziehungen (wie #top)

schon erledigt:

- JavaScript-Extraktion

- robots.txt Standard einhalten

- Basic Authentication (Zugang zu kennwortgeschützten Bereichen, einstellbar)

- X.509 Zertifikate nutzen (einstellbar)

- Proxy ggf. nutzen (einstellbar)

- Integration in unser CMS .webtop

- Text-Extraction (noch in der Testphase)

- Extraktion von CSS-Angaben aus style-Attributen der Tags

Änderungen / Versionshistorie

- 2012-06-29, Caching prüfen, ein Bild sollte Expires oder max-age Header setzen von aktuell mindestens 48 h

- 2012-06-28, Neu:

- HTML5

Weitere HTML5-Tags und Attribute werden geprüft, einige bestehende Prüfungen wurden verfeinert oder erweitert. -

Agiler HTML-Parser als Fallback

Der HTML-Parser fällt vom XML-Modus in einen „agilen“ HTML-Modus zurück, um auch nicht XML-konformes HTML prüfen zu können (basiert auf dem HTML Agility Pack). - Bilder prüfen

Nach einem Durchlauf kann die neue Funktion Check Images aufgerufen werden. Diese prüft die beim ersten Validierungslauf gefundenen Web-Bilder auf Korrektheit und Komprimierbarkeit.

Der Jpeg-Kompressionslevel für den Vergleichsmaßstab kann frei eingestellt werden, ebenso die mindestens zu erreichende Einsparung in Prozent, ab der eine Meldung erfolgt.

Bilder mit „vielen“ Metadaten werden protokolliert, da es sich evtl. um ein unerwünschtes Informationsleck handelt, zumindest aber der Nutzen dieser Daten innerhalb einer Webseite fraglich ist. - Das Flackern beim Hinzufügen neuer Informationen zur Ausgabetabelle tritt nicht mehr auf.

- wespiva wird nun als .NET 4.0-Anwendung kompiliert

- HTML5

- 2011-06-08, Fehler bei Link-Redirect beseitigt, provisorischer HTML5-Support, Website-URL mit in der Projektdatei speichern

- 2010-01-27, einige kleinere Fehler beseitigt, Option um JavaScript zu extrahieren aus den besuchten Seiten, Multithreaded Validation (=speedup)

- 2008-12-19, version 0.1.9: robots.txt, Parsing-Problem beseitigt

Andere XHTML-Validatoren

Die folgenden Validatoren sind empfehlenswert, auch wenn sie nicht ganze Sites prüfen: